AI瑕疵检测系统在工业生产和质量控制中发挥着越来越重要的作用,其性能却受到多方面的限制和挑战。本文将从几个关键方面探讨这些性能瓶颈,分析其影响和可能的解决方案。

数据质量与标注

AI瑕疵检测系统的性能首先受到数据质量的影响。有效的训练需要大量高质量的数据,但实际情况中,工业生产中的数据往往不完整、噪声干扰大,甚至存在标注错误。这些问题直接影响模型的准确性和泛化能力。研究表明(引用数据),在数据标注的过程中,人为因素可能导致标签的不一致性,从而影响到模型的训练效果。提高数据质量和标注的准确性成为提升系统性能的重要一环。

计算资源与效率

另一个关键因素是计算资源和效率。复杂的深度学习模型需要大量的计算资源支持,包括高性能的GPU和大规模的存储系统。在实际应用中,这些资源的成本和可用性可能限制了系统的规模和速度。特别是在实时瑕疵检测的场景下,对计算效率的要求更加严格。研究人员和工程师们正致力于优化算法,减少计算负载,提高系统的实时性和响应速度。

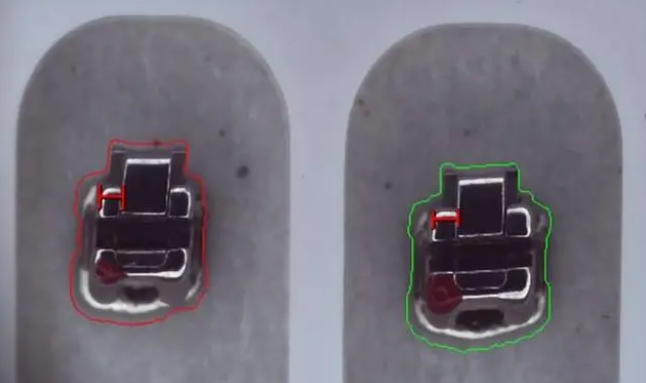

复杂瑕疵和多样性检测

AI瑕疵检测系统在面对复杂瑕疵和多样性检测时也面临挑战。传统的缺陷可能有明确的特征和规律可循,但实际生产中的瑕疵可能十分复杂,形态各异,甚至难以定义和识别。这些情况下,单一模型往往无法胜任所有检测任务,需要结合多种技术和策略,如图像增强、多尺度检测等,以提升检测的全面性和准确性。

模型解释性与可解释性

随着AI技术的发展,模型的解释性和可解释性日益受到关注。在瑕疵检测系统中,准确性和可信度很大程度上取决于模型的解释能力,即模型如何理解和识别瑕疵特征。当前的深度学习模型往往是黑盒子,缺乏直观的解释能力,这给工程师们带来了挑战,尤其是在需要验证和审查检测结果时。研究人员正在积极探索提高模型解释性的方法和技术,以增强系统的可靠性和透明度。

数据隐私与安全

数据隐私和安全也是影响AI瑕疵检测系统的关键因素之一。工业生产中的数据可能涉及商业机密和个人隐私,如何在保证数据安全的前提下进行有效的数据共享和模型训练成为一项技术和法律挑战。例如,联邦学习和加密计算等技术被提出用于解决数据隐私和安全问题,但其在实际应用中的可行性和效果仍需进一步研究和验证。

AI瑕疵检测系统面临着多方面的性能瓶颈,包括数据质量、计算资源、复杂瑕疵检测、模型解释性和数据安全等问题。解决这些挑战需要跨学科的合作和持续的技术创新。未来的研究可以集中在提高数据质量、优化算法效率、增强模型解释性和加强数据安全等方面,以推动AI瑕疵检测系统的发展,更好地服务于工业生产和质量管理的需求。